|

(사진=셔터스톡) |

<이미지를 클릭하시면 크게 보실 수 있습니다> |

중국 칭화대 연구진이 언어 처리와 비전 기능을 결합한 경량형 멀티모달모델(LMM)을 공개했다. 클라우드 서버와의 연결 없이 엣지 디바이스에서 실행이 가능하도록 설계, 온디바이스 인공지능(AI) 환경에 최적화된 것이 특징이다.

마크테크포스트는 29일(현지시간) 칭화대 연구진이 에지 디바이스에서 로컬로 실행할 수 있는 온디바이스 AI용 LMM인 'GLM-에지(GLM-Edge)' 시리즈를 오픈 소스로 출시했다고 보도했다.

이 모델군은 15억~50억개의 매개변수를 포함하고 있으며, 언어와 비전 기능을 하나의 모델로 통합해 자원이 제한된 디바이스 환경에서 최적화된 솔루션을 제공한다. 언어 기능은 복잡한 대화를 낮은 지연 시간으로 처리할 수 있고, 비전 기능은 객체 감지와 이미지 캡션 생성 등 다양한 컴퓨터 비전 작업을 실시간으로 지원한다.

GLM-에지 시리즈는 GLM(General Language Model) 아키텍처를 기반으로, 양자화(quantization) 기술과 구조 개선을 통해 에지 환경에서의 활용성을 극대화했다.

또 지식 증류(knowledge distillation)와 프루닝(pruning)을 결합해 학습했다. 이를 통해 모델 크기를 크게 줄이면서도 높은 정확도를 유지했다. 특히 8비트와 4비트 양자화를 적용하여 메모리와 계산 요구량을 줄임으로써, 제한된 자원을 가진 소형 디바이스에서도 실행이 가능하게 설계됐다.

클라우드 서버 없이도 강력한 AI 기능을 발휘할 수 있기 때문에 데이터를 로컬에서 처리해 비용 효율성을 높이는 동시에 개인정보 보호와 보안에도 유리하다. 이는 특히 개인정보 보호, 낮은 지연 시간, 오프라인 작동이 중요한 애플리케이션에서 유용하다.

|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

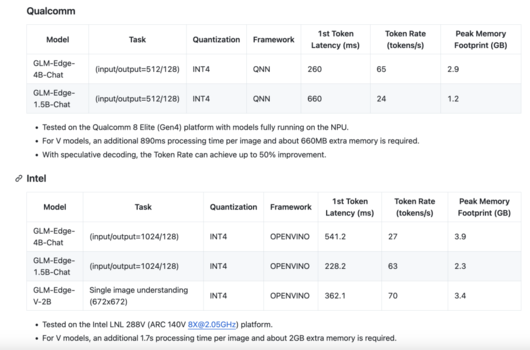

벤치마크 평가에서 뛰어난 성능을 입증했다.

GLM-에지-1.5B 모델은 언어 처리 및 비전 벤치마크에서 훨씬 더 큰 트랜스포머 모델에 필적하는 성과를 보였다. 또 키워드 감지나 실시간 비디오 분석 등 에지 환경에서 필요한 작업에서도 우수한 성능을 보여주며, 모델 크기, 지연 시간, 정확도 간의 균형을 성공적으로 달성했다.

현재 GLM-에지 시리즈는 깃허브와 허깅페이스를 통해 다운로드할 수 있으며, 상업적 용도로도 활용 가능하다.

박찬 기자 cpark@aitimes.com

<저작권자 Copyright ⓒ AI타임스 무단전재 및 재배포 금지>

이 기사의 카테고리는 언론사의 분류를 따릅니다.

기사가 속한 카테고리는 언론사가 분류합니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.