네이버클라우드, 삼성과 손잡고 맞춤형 제작 착수

엔비디아 보다 양산 쉬워 가격경쟁력 커질 듯

네이버 LLM '하이퍼클로바X' 활용

|

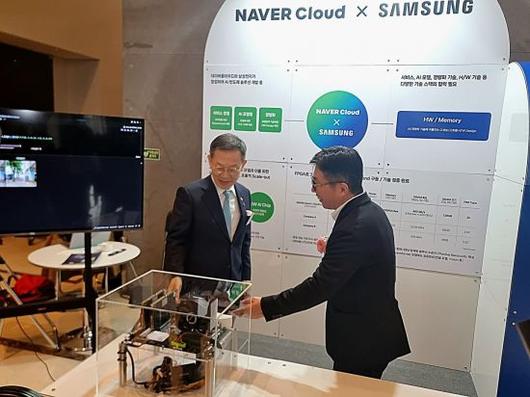

이종호 과학기술정보통신부 장관이 19일 '2023 인공지능 반도체 미래기술 컨퍼런스'에서 김유원 네이버클라우드 대표로부터 네이버클라우드가 삼성전자와 개발한 AI 반도체에 대해 설명을 듣고 있다. |

<이미지를 클릭하시면 크게 보실 수 있습니다> |

네이버가 늦어도 2025년 상반기까지 자체 인공지능(AI) 반도체를 선보일 전망이다.

김유원 네이버클라우드 대표는 19일 과학기술정보통신부가 주최한 ‘2023 인공지능 반도체 미래기술 컨퍼런스’에서 아시아경제 기자와 만나 "AI 반도체 시제품을 늦어도 1년 6개월 내엔 완성할 것"이라고 밝혔다. 네이버클라우드는 삼성전자와 함께 국산 AI반도체를 개발 중이다.

김 대표는 이어 "네이버클라우드에 먼저 적용하고 기업간(B2B)용 판매에도 나설 것"이라면서도 구체적인 양산 시점이나 판매방식은 파트너사인 삼성과 협의가 필요하다고 덧붙였다.

네이버클라우드가 개발중인 칩은 용도에 맞게 프로그래밍할 수 있는 FPGA(Field Programmable Gate Array)로, AI 모델이 입력된 데이터를 바탕으로 논리적인 결론에 이르는 ‘추론’에 특화돼 있다. 엔비디아 AI 반도체칩이 학습·추론형 모두에 강점을 보인다면, 네이버클라우드는 자체 거대언어모델(LLM)인 ‘하이퍼클로바X’와의 연계성을 고려해 처음부터 추론형에 집중했다.

이종호 과기정통부 장관은 이날 공개된 검증용 FPGA 보드로 네이버 하이퍼클로바X를 동작하는 모습에 관심을 보였다. 네이버클라우드는 시제품 개발이 완료되기 전 단계임에도 모델을 손쉽게 구현했다.

|

검증용 FPGA 보드로 네이버 LLM '하이퍼클로바X'를 동작하는 모습 |

<이미지를 클릭하시면 크게 보실 수 있습니다> |

이번 AI 반도체의 형태는 LPDDR(저전력D램)이다. 이동수 네이버클라우드 이사는 "엔비디아의 HBM(고대역폭메모리)는 하나하나 손수 수를 놓는 수공예에 빗댈 수 있다"며 "이에 비해 LPDDR은 양산이 가능하기 때문에 가격경쟁력이 있을 것"이라고 설명했다. 전세계적인 반도체 공급난 속에서 HBM을 효과적으로 대체할 수 있을 것이란 기대감이 존재한다.

특히 AI 모델 크기를 줄여 구동하는 경량화 기술에서 성과를 냈다. 거대언어모델(LLM)을 압축하고 연산 성능도 높였다. 전력 효율 측면에서도 동일 성능 기준 타사 솔루션 대비 8배 이상으로 효율을 끌어올릴 수 있다고 보고 있다. 일반 반도체업계에서 압축 과정에서 언어모델 성능이 떨어지는 것을 우려하지만, 네이버클라우드는 자체 언어모델을 보유하고 있어 이 같은 리스크에서 비교적 자유로웠기에 새롭게 도전할 수 있었다는 설명이다. 데이터센터 운영비용을 낮추는 데도 일조할 전망이다. 데이터센터는 운영 비용의 70~80%가 전력 비용일 정도로 '전기 먹는 하마'로 불린다.

반도체업계서는 전 세계 시장 규모가 2030년 1조달러(약 1308조원)를 돌파할 것으로 관측되고 있다. 글로벌 컨설팅 회사 매킨지는 반도체 산업 전망 보고서에서 이같이 예상한 바 있다. 김형준 차세대지능형반도체사업단 단장은 이날 행사에서 "당초 2030년으로 예견됐지만 2027년으로 1조달러 돌파가 앞당겨질 것으로 보인다"며 챗GPT의 도입과 AI 기술로 인한 반도체 시장 발전에 기대감을 표했다.

한편, 이날 행사에는 AI 반도체와 클라우드사 등 25곳이 참석했다.

차민영 기자 blooming@asiae.co.kr

<ⓒ투자가를 위한 경제콘텐츠 플랫폼, 아시아경제(www.asiae.co.kr) 무단전재 배포금지>

이 기사의 카테고리는 언론사의 분류를 따릅니다.

기사가 속한 카테고리는 언론사가 분류합니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.