|

(사진=셔터스톡) |

<이미지를 클릭하시면 크게 보실 수 있습니다> |

대형언어모델(LLM)은 실제로 추론을 하는 것이 아니라, 학습 데이터에서 관찰한 패턴을 복제하는 것이라는 연구 결과가 나왔다. LLM이 실제 개념을 이해하지 못한다는 것은 이미 잘 알려진 일로, 이번 연구는 최근 추론 능력을 강조하는 오픈AI의 'o1'을 겨냥한 것으로 보인다. 결국 o1도 기존 LLM과 다를 것이 없다는 지적이다.

테크크런치는 11일(현지시간) 애플이 현재의 LLM들은 실제 논리적 추론을 할 수 없으며, 대신 학습 데이터에서 관찰된 추론 단계를 복제하려고 시도한다고 주장하는 논문을 아카이브에 게재했다고 보도했다.

최근 수학 문제 해결 능력이 LLM의 추론 능력을 평가하는 기준으로 주목받고 있다.

오픈AI의 o1을 비롯, 수학 추론 능력을 강조한 새로운 모델들이 나오고 있다. 최근 몇 년 동안 수학 문제에 대한 모델의 수학적 추론 능력을 평가하는 벤치마크에서 LLM의 성능이 크게 향상된 것도 사실이다.

연구진은 "이런 모델들의 수학적 추론 능력이 실제로 발전했는지에 대해서는 여전히 의문이 제기되며, 보고된 지표의 신뢰성에 대한 문제도 남아 있다"라고 지적했다.

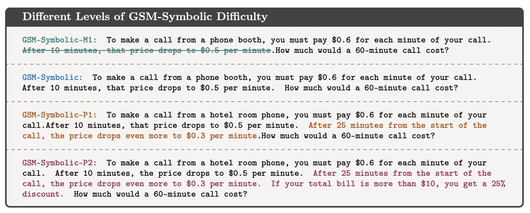

특히 벤치마크에서 질문의 숫자 값만 변경해도 대부분 LLM의 성능이 하락하는 것으로 나타났다고 밝혔다.

질문과 관련 있어 보이지만 최종 답을 도출하는 데 영향을 주지 않는 구절을 하나만 추가해도, 모든 최신 모델은 성능이 최대 65%까지 하락했다. 또 질문에 포함된 구절의 수가 증가할수록 모델의 성능이 크게 저하된다고 덧붙였다.

예를 들어, "올리버는 금요일에 키위를 44개 따고, 토요일에는 58개를 땄다. 일요일에는 금요일에 딴 키위의 두배를 땄다. 올리버는 총 몇개의 키위를 가지고 있을까"라고 질문했을 때, LLM은 "44+58+(44*2)=190"라고 비교적 문제를 잘 풀었다.

하지만 약간의 추가 정보를 추가해 "올리버는 금요일에 키위를 44개 따고, 토요일에는 58개를 땄다. 일요일에는 금요일에 딴 키위의 두 배를 땄는데, 그중 5개는 평균보다 조금 작았다. 올리버는 총 몇 개의 키위를 가지고 있을까"라고 질문했을 때 결과는 달랐다. 작은 키위도 키위라는 점에서 앞선 질문과 같은 문제지만, 최신 LLM조차도 혼란스러워했다.

오픈AI의 'o1-미니'는 "이 중 5개의 키위가 평균보다 작았다. 따라서 일요일의 총량에서 이들을 빼야 한다: 88(일요일의 키위)–5(작은 키위)=83개 키위"라고 틀린 답을 내놓았다.

|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

이는 내용을 약간 수정한 수백개 질문 중 하나에 불과하다. 거의 모든 경우에서 모델의 성공률이 크게 감소하는 결과를 초래했다고 전했다.

연구진은 이에 대해 "모델이 실제로 문제를 전혀 이해하지 못하고 있다는 것을 의미한다"라고 지적했다.

모델의 학습 데이터는 특정 상황에서 올바른 답변을 제공할 수 있게 하지만, 작은 키위를 셀지 말지와 같은 약간의 실제 추론이 필요해지는 순간, 모델은 이상하고 직관적이지 않은 결과를 만들어내기 시작한다는 것이다. 이는 현재 LLM들이 실제 논리적 추론을 할 수 없으며, 대신 학습 데이터에서 관찰된 추론 단계를 복제하려고 시도하기 때문이라고 주장했다.

이에 대해 오픈AI는 반박했다. 보아즈 바락 오픈AI 연구원은 X(트위터)에서 이 연구를 칭찬하면서도 "약간의 프롬프트 엔지니어링을 적용하기만 해도 이런 테스트에서 올바른 결과를 얻을 수 있을 것"이라고 주장했다.

논문 공동 저자인 메흐르다드 파라즈타바르는 "더 나은 프롬프트가 단순한 변형에는 효과적일 수 있지만, 모델이 복잡한 방해 요소를 극복하기 위해서는 기하급수적으로 더 많은 컨텍스트 데이터가 필요할 수 있다"라며 프롬프트 엔지니어링은 근본적인 해결책이 아니라고 지적했다.

그는 "LLM을 방해한 요소는 어린아이도 구별할 수 있을 정도로 쉬운 것"이라고 말했다.

LLM이 실제 사물을 이해하지 못한다는 지적은 상식에 가깝다. 대표적인 예가 단어에 포함된 알파벳 자체를 이해하지 못하며, 단지 토큰으로만 읽어낸다는 것이다. 따라서 LLM은 '스트로베리(strawberry)'에 'r'이 몇개 포함됐는지 모른다는 것은 유명한 사실이다.

o1은 이런 문제에서 정확도가 많이 향상된 것으로 알려졌다. 하지만, 애플은 아직도 추론이 가능하지 않다는 것을 재차 확인한 것이다.

박찬 기자 cpark@aitimes.com

<저작권자 Copyright ⓒ AI타임스 무단전재 및 재배포 금지>

이 기사의 카테고리는 언론사의 분류를 따릅니다.

기사가 속한 카테고리는 언론사가 분류합니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.