|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

최근 오픈 소스 진영에서도 주류를 이루는 인공지능(AI) 추론 모델이 기존 모델보다 압도적으로 많은 전력을 소비한다는 연구 결과가 나왔다.

사샤 루치오니 허깅페이스 연구원과 보리스 가마자이치코프 세일즈포스 AI 지속가능성 총괄이 'AI 에너지 스코어(AI Energy Score)' 프로젝트는 4일(현지시간) 오픈AI와 구글, 딥시크 등의 개방형 모델 40종을 같은 하드웨어에서 같은 프롬프트로 테스트, 전력 소비를 측정했다고 밝혔다.

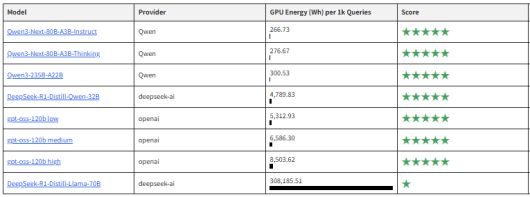

그 결과, 추론 능력을 갖춘 AI 모델은 프롬프트 1000개를 처리하는 과정에서 일반 모델보다 평균 100배 이상 많은 전력을 소모했다.

또 추론 과정에서는 기본 모델보다 300~800배 더 많은 출력 토큰을 생성하는 것으로 밝혀졌다.

이중 '딥시크-R1'의 증류(Distillation) 버전인 '딥시크-R1-증류-라마-70B' 모델은 추론 기능을 끄면 50와트시(Wh), 즉 50W짜리 전구를 한시간 동안 켤 수 있는 적은 전력을 소모했다. 그러나, 추론 기능을 가동하면 무려 30만8186Wh를 소비한 것으로 나타났다.

이는 비추론 모드의 6222배에 달하는 수치다. 이처럼 극단적인 에너지 증가를 보인 이유는 이 모델이 추론 시 여러 단계의 긴 사고 토큰을 생성하기 때문이다. 이를 통해 정확도를 올린 것이다.

|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

연구진은 각 모델이 추론을 생성하는 과정에서 방식과 상세함 정도가 다르기 때문에 단순히 매개변수의 크기만으로는 에너지 사용량을 예측하기 어렵다고 덧붙였다.

실제로 MS의 '파이(Phi) 4' 추론 모델은 기능을 끄면 18Wh만 소모했지만, 활성화 시에는 9462Wh까지 증가했다. 오픈AI의 'gpt-oss-120B'는 추론 강도를 높이면 8504Wh, 낮추면 5313Wh로 차이가 상대적으로 적었다.

루치오니 총괄은 "모든 질의에 고비용·고전력의 추론형 모델을 사용할 필요는 없다"라며 "작업에 따라 적절한 모델을 사용하는 'AI 효율'이 중요하다"라고 강조했다.

|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

AI 전력 소모 증가는 이미 글로벌 전력망에 부담을 주고 있다. 미국 데이터센터 밀집 지역의 도매 전력 요금은 최근 5년간 최대 267% 상승했다. 마이크로소프트, 구글, 아마존도 데이터센터 확장이 장기적으로 기후 목표에 위협이 될 수 있다고 인정한 바 있다.

추론 모델은 대규모 학습뿐 아니라, 모델 서비스 과정에서도 많은 계산을 요구하기 때문에 에너지 부하가 더 커질 전망이다.

한편, 구글은 최근 자체 연구를 통해 "제미나이에서는 평균 텍스트 프롬프트 1개 처리에 약 0.24Wh만 사용된다"라고 주장한 바 있다.

그러나 이번 연구 결과는 고성능 추론 모델의 소비 전력이 훨씬 높게 나타났다. 이는 측정 방식의 차이에 따른 것이지만, 구글의 결과가 실제 전력 소비를 정확하게 반영하는가로 논쟁이 이어질 수 있다는 지적이다.

박찬 기자 cpark@aitimes.com

<저작권자 Copyright ⓒ AI타임스 무단전재 및 재배포 금지>

이 기사의 카테고리는 언론사의 분류를 따릅니다.

기사가 속한 카테고리는 언론사가 분류합니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.