|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

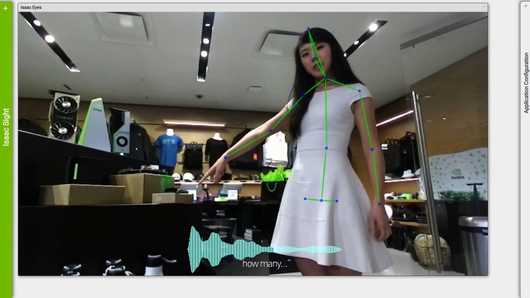

[smartPC사랑=임병선 기자] AI 컴퓨팅 기술 분야의 선두주자인 엔비디아(CEO: 젠슨 황)는 실시간 대화형 인공지능(AI)을 통해 기업이 고객과 보다 자연스럽게 소통할 수 있는 언어이해 모델을 발표했다.

엔비디아의 AI 플랫폼은 최첨단 AI 언어모델 중 하나인 버트(Bidirectional Encoder Representations from Transformers, 이하 BERT)를 한 시간 내에 훈련시키고, 2ms 만에 AI 인퍼런스를 완료한 최초의 모델이다. 이 획기적인 성능 수준을 통해 개발자는 전 세계 수억 명의 소비자가 사용할 수 있는 대규모 애플리케이션용 최신 언어이해 기능을 사용할 수 있다.

마이크로소프트(Microsoft)와 세계에서 가장 혁신적인 몇몇 스타트업을 포함한 기업들은 초기부터 엔비디아를 채택해 성능 향상을 확인했다. 이들은 엔비디아 플랫폼을 활용해 자사의 고객을 위해 매우 직관적이고 즉각적인 반응형 언어 기반 서비스를 개발하고 있다.

대화형 AI 서비스는 몇 년 동안 제한적으로 존재해왔다. 현재까지 엄청나게 방대한 AI 모델을 배치하는 것이 불가능해 챗봇, 지능형 개인 비서, 검색 엔진 서비스가 인간 수준의 이해력 갖춘 채로 작동되기는 매우 어려웠다. 엔비디아는 AI 플랫폼에 핵심 최적화 기능을 추가해 이러한 문제를 해결했으며, AI 훈련과 인퍼런스를 기록적인 속도로 수행하고, 현재까지 가장 방대한 언어 모델을 구축했다.

엔비디아 응용 딥 러닝 리서치(Applied Deep Learning Research) 부사장 브라이언 카탄자로(Bryan Catanzaro)는 "대화형 언어 모델은 자연어용 AI를 혁신시키고 있다. 이는 우리가 예외적으로 어려운 언어 문제를 해결하도록 도와주고 있다"며 "엔비디아는 이러한 모델을 가속화하는 획기적인 작업을 통해 이전에는 상상도 못했던 방식으로 고객을 돕고 이들을 기쁘게 할 수 있는 새로운 첨단 서비스를 만들 고 있다"고 말했다.

가장 빠른 훈련과 인퍼런스 그리고 가장 방대한 모델

자연어 이해에 기반한 AI 서비스는 향후 몇 년 동안 기하급수적으로 성장할 것으로 예상된다. 실제로, 주니퍼리서치(Juniper Research)는 디지털 음성 비서만의 사용건수가 향후 4년 내에 25억에서 80억으로 증가할 것으로 예측했다. 또한, 가트너(Gartner)는 2021년까지 모든 고객 서비스 상호작용의 15%가 AI로 완전히 처리되고, 2017년도 대비 400% 증가할 것으로 예측했다.

엔비디아는 이 새로운 시대를 선도하기 위해 핵심 최적화를 통해 AI 플랫폼을 미세하게 조정했다. 다음은 엔비디아가 자연어 성능과 관련해 기록한 세 가지 성과다.

- 가장 빠른 훈련: 세계에서 가장 진보된 AI 언어모델 중 하나인 BERT의 가장 방대한 버전을 수행한다. 1,472개의 엔비디아 V100 GPU를 실행해 924개의 엔비디아 DGX-2H 시스템을 사용하는 엔비디아 DGX 슈퍼POD(DGX SuperPOD)를 통해 며칠이 소요되던 BERT-라지(BERT-Large)의 훈련 시간을 53분으로 단축했다.

- 가장 빠른 인퍼런스: 엔비디아 텐서RT(TensorRT)를 사용하는 엔비디아 T4 GPU를 통해 엔비디아는 BERT-베이스 스쿼드(BERT-Base SQuAD) 데이터세트를 단 2.2ms만에 인퍼런스했다.

- 가장 방대한 모델: 엔비디아 리서치는 점점 더 방대한 모델을 요구하는 개발자의 요청에 부응해 BERT에 사용되는 기술 빌딩 블록(building block)과 점점 더 늘어나는 다른 자연어 AI 모델을 기반으로 세계 최대 언어모델을 구축하고 훈련시켰다. 엔비디아의 맟춤형 모델은 83억 개의 매개변수를 가졌으며, BERT-라지 크기의 24배다.

생태계 인용문

전 세계 수백 명의 개발자들이 이미 엔비디아의 AI 플랫폼을 사용해 각자의 언어이해 연구를 발전시키고 새로운 서비스 개발에 몰두하고 있다.

마이크로소프트 빙(Bing)은 자사의 애저(Azure) AI 플랫폼과 엔비디아 기술을 활용해 BERT를 실행하고 보다 정확한 검색 결과를 이끌어내고 있다.

마이크로소프트 빙 그룹 프로그램 매니저 랑간 마줌더(Rangan Majumder)는 "마이크로소프트 빙은 엔비디아와 긴밀한 협력으로 애저 AI 인프라의 일부인 엔비디아 GPU를 활용해 인기 자연어 모델 BERT를 최적화시켰고, 지난해 빙의 순위 검색 품질을 가장 크게 향상시켰다"며 "애저 엔비디아 GPU를 사용해 CPU 기반 플랫폼 대비 레이턴시(latency)를 두 배 단축하고 처리량을 다섯 배 향상시켰다. 그 결과, 빙은 전 세계 모든 고객에게 보다 적절하고 비용 효율적인 실시간 검색 환경을 제공할 수 있게 됐다"고 말했다.

클린크(Clinc), 패세지 AI(Passage AI), 레코저(Recordsure)를 포함한 엔비디아의 인셉션(Inception) 프로그램에 참여하는 여러 스타트업도 엔비디아의 AI 플랫폼을 사용하여 은행, 자동차 제조업체, 소매업체, 의료 사업자, 여행 및 서비스업체 등을 위한 최첨단 대화형 AI 서비스를 구축하고 있다.

클린크는 바클레이즈(Barclays), USAA, 터키 최규모 은행 이스방크(Isbank)와 같은 세계 유수의 금융 기관과 자동차 제조업체, 의료기관 등을 포함한 고객 목록을 통해 전 세계 3천만 명 이상의 사람들이 엔비디아 GPU가 지원하는 대화형 AI 솔루션을 이용할 수 있도록 했다.

클린크 CEO 제이슨 마스(Jason Mars)는 "클린크의 선도적인 AI 플랫폼은 복잡한 질문을 이해하고, 통찰력 있는 분석으로 세계 선두 브랜드들이 곧바로 실행할 수 있는 강력한 결과를 내놓는다"며 "엔비디아의 AI 플랫폼이 제공하는 혁신적인 성능 덕분에 대화형 AI의 경계는 확장되고 있다. 덕분에 우리는 우리의 고객이 기술을 통해 더욱 강력하고 유의미한 방식으로 소통할 수 있도록 지원하는 서비스를 제공할 수 있다"고 말했다.

AI 최적화 기능 제공

엔비디아는 개발자들이 대화형 AI에서 이러한 혁신을 달성하는 데 필요한 소프트웨어를 최적화했다.

- 파이토치(PyTorch)를 사용한 엔비디아 깃허브(GitHub) BERT 트레이닝 코드

- NGC 모델 스크립트 및 텐서플로우(TensorFlow)용 체크포인트

- 깃허브의 텐서RT 최적화 BERT 샘플

- 더 빠른 트랜스포머(Transformer): C++ API, 텐서RT 플러그인 및 텐서플로우 OP

- BERT(훈련 및 인퍼런스)용 AMP를 지원하는 MXNet 글루온-NLP(Gluon-NLP)

- AI Hub의 텐서RT 최적화 BERT 쥬피터(Jupyter) 노트북

- 메가트론LM(MegatronLM): 대규모 트렌스포머 모델 훈련을 위한 파이토치 코드

추가자료

- 엔비디아 비디오: 대화형 AI의 다음 단계

- 엔비디아 개발자 블로그: 텐서RT와 BERT를 통한 실시간 자연어 이해

- 엔비디아 응용 딥 러닝 블로그: 메그트론LM: GPU 모델 병렬처리를 사용해 10억 개 이상의 매개변수 언어 모델 훈련

<저작권자 Copyright ⓒ 스마트PC사랑 무단전재 및 재배포 금지>

이 기사의 카테고리는 언론사의 분류를 따릅니다.

기사가 속한 카테고리는 언론사가 분류합니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.