내년 2분기 출시 예상…조만간 나오는 AMD의 MI300X와 경쟁

|

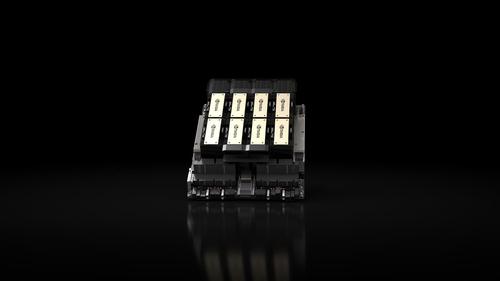

엔비디아의 최신 AI 칩 H200 |

(샌프란시스코=연합뉴스) 김태종 특파원 = 인공지능(AI) 반도체 부문 선두 주자인 미국의 엔비디아가 최신 AI 칩을 내놓았다.

엔비디아는 13일(현지시간) 생성형 AI 모델의 기반이 되는 대규모 언어 모델(LLM)에 적용해 이를 훈련하도록 설계된 그래픽처리장치(GPU) H200을 공개했다.

H200은 챗GPT 개발사 오픈AI의 최신 LLM인 GPT-4 훈련에 적용되는 등 전 세계 기업들이 확보하기 위해 경쟁을 벌이는 H100의 업그레이드 버전이다.

현재 H100 칩 1개당 가격은 2만5천달러∼4만달러로 추정되고 있으며, LLM을 구동하는 데에는 수천 개의 칩이 필요하다. H200의 가격은 알려지지 않았다.

H200에는 141기가바이트(GB)의 차세대 메모리 'HBM3'가 탑재됐다.

고대역폭 메모리를 뜻하는 HBM(High Bandwidth Memory)은 여러 개의 D램을 수직으로 연결해 데이터 처리 속도를 혁신적으로 끌어올린 고성능 제품이다.

HBM3은 HBM의 4세대 제품으로 칩이 텍스트와 이미지 등을 생성하기 위해 훈련된 LLM이 추론하는 데에도 도움을 준다.

엔비디아는 H200을 메타의 LLM인 라마2에 사용한 테스트를 근거로 H100보다 2배 빠른 출력을 낸다고 설명했다.

또 H200은 H100과 호환된다며 H100을 확보한 AI 기업들이 새로운 버전을 사용하기 위해 서버 시스템이나 소프트웨어를 바꿀 필요가 없다고 덧붙였다.

아울러 이 칩은 H200 GPU와 암(Arm) 기반 프로세서를 결합한 'GH200'이라는 칩과 엔비디아의 컴퓨팅 플랫폼인 HGX의 서버 구성에 사용될 수 있다고 전했다.

H200은 내년 2분기 본격적인 출시가 예상된다. 이에 따라 출시를 앞둔 미 반도체 기업 AMD의 MI300X 칩과 경쟁이 예상된다.

AMD는 앞서 지난 6월 MI300X 칩을 발표하고 연말부터 본격 출시에 들어간다고 밝힌 바 있다. MI300X 칩은 엔비디아 H100 대비 2.4배 메모리 밀도와 1.6배 이상의 대역폭(bandwidth)을 제공한다.

H200은 H100과 함께 엔비디아의 가속 컴퓨팅 플랫폼인 호퍼(Hopper) 아키텍처를 기반으로 한다.

엔비디아는 지난달 반도체의 중요한 성능 향상을 가져오는 아키텍처 전환을 2년에서 1년으로 앞당겨 내년에는 블랙웰(Blackwell) 아키텍처를 기반으로 한 B100 칩 출시를 예고한 바 있다.

taejong75@yna.co.kr

▶제보는 카카오톡 okjebo

▶연합뉴스 앱 지금 바로 다운받기~

▶네이버 연합뉴스 채널 구독하기

<저작권자(c) 연합뉴스, 무단 전재-재배포 금지>

이 기사의 카테고리는 언론사의 분류를 따릅니다.

기사가 속한 카테고리는 언론사가 분류합니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.