<이미지를 클릭하시면 크게 보실 수 있습니다> |

연초 중국발 '딥시크 쇼크'로 큰 충격을 받은 미국 빅테크들의 생성형 AI 전략을 가다듬으며 반격에 나서고 있다.

'물 들어올 때 노 젓는' 오픈AI

7일 외신 등에 따르면 샘 올트먼 오픈AI 최고경영자(CEO)는 자신의 엑스(X) 계정을 통해 "몇 주 안에 'o3'와 'o4-미니'를 출시할 것"이라며 "몇 달 안에 GPT-5를 출시할 예정"이라고 밝혔다.

앞서 지난달 올트먼 CEO는 차세대 추론 모델 'o3' 출시 없이 'GPT-5'에 추론 기능을 통합할 것이라 밝힌 바 있으나, 최근 신규 이미지 생성 모델이 '지브리풍 신드롬'을 일으키며 챗GPT 수요가 급등하자 다시 전략적 변화를 택한 것으로 풀이된다.

<이미지를 클릭하시면 크게 보실 수 있습니다> |

현재 상승세를 이어가기 위해 다양한 추론 모델을 보다 신속하게 선보이고, 충분한 인프라를 확보한 이후 GPT-5를 내놓겠다는 복안이다. 다만 GPT-5 출시가 계속 밀리고 있는 건 범용인공지능(AGI)급 성능을 지닌 것으로 알려진 GPT-5 개발이 쉽지만은 않은 것으로도 풀이할 수 있다.

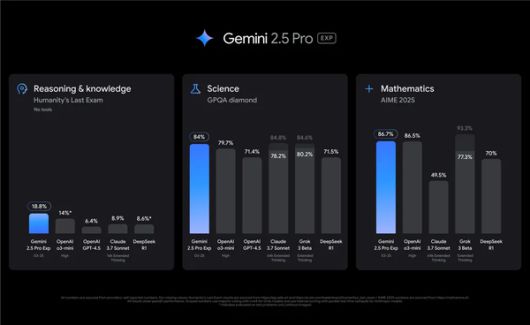

제미나이, 통 크고 저렴하게

AI 기술 분야의 리더십 회복에 갈 길이 바쁜 구글은 '제미나이'의 성능 뿐만 아니라 비용 효율성을 높이는 데도 주목하고 있다. 제미나이의 강점은 멀티모달 처리 능력과 긴 컨텍스트 창으로, 동급 모델 대비 낮은 애플리케이션 프로그래밍 인터페이스(API) 비용을 책정하고 나섰다.

최근 공개된 구글의 고급 추론 모델인 '제미나이 2.5 프로'는 최대 100만 토큰, 향후 200만 토큰의 컨텍스트 창을 지원하며, 20만 미만 토큰을 프롬프트 하는 경우 입력 토큰 100만개 당 1.25달러, 출력 토큰 100만개 당 10달러의 API 비용을 책정했다. 또 20만개 이상의 토큰을 프롬프트 하는 경우 입력 토큰 100만개 당 2.5달러, 출력 토큰 백만 개당 15달러의 비용이 든다.

<이미지를 클릭하시면 크게 보실 수 있습니다> |

이는 구글의 역대 AI 모델 중에는 가장 비싼 가격이지만, 토큰 100만개 당 처리 가격으로 비교했을 때 앤스로픽의 '클로드 3.7'(입력 토큰 3달러, 출력 토큰 15달러), 오픈AI의 'GPT-4.5'(입력 토큰 75달러, 출력 토큰 150달러)에 비하면 훨씬 저렴한 수준이다. 현지 언론에 따르면 개발자들의 반응은 대채로 긍정적이며, 합리적인 가격이라고 평가하고 있는 분위기다.

경량 모델인 '제미나이 2.0 플래시'는 입력 토큰 100만개당 0.10달러, 출력 토큰 100만개당 0.40달러로 제공된다. 오픈AI의 'o3-미니'는 입력 토큰 1.10달러, 출력 토큰 4.40달러, '딥시크-R1'은 입력 토큰 0.55달러, 출력 토큰 2.19달러의 비용이 든다.

향후 추론 모델이 대세가 되면서 고급 모델의 API 비용은 계속해서 상승할 것으로 전망된다. 최근 출시된 오픈AI의 'o1-프로'의 경우 입력 토큰당 150달러, 출력 토큰당 600달러라는 역대 가장 비싼 API 가격을 책정하기도 했다. 알트먼 CEO가 "GPU가 녹고 있다"고 표현할 만큼 컴퓨팅 비용과 수요가 여전히 폭증하고 있는 가운데, 가격 상승 압력에 대응하는 능력이 AI 모델 채택에 중요한 분기점이 될 것으로 전망된다.

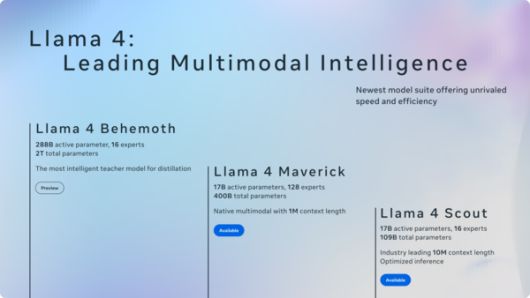

메타, '라마 4'로 오픈소스 전략 강화

먼저 공개한 '라마 4 스카우트'는 170억개 활성 매개변수 모델로, 컨텍스트 창 크기를 1000만 토큰으로 확장한 개 특징이다. 벤치마크 테스트에서 '제미나이 3', '제미나이 2.0 플래시-라이트', '미스트랄 3.1' 등 경쟁 모델 대비 우수한 성적을 거뒀다고 메타 측은 설명했다.

함께 출시된 '라마 4 매버릭'은 더 넓은 범위의 작업에서 높은 성능을 제공, 특정 산업이나 응용 분야에서의 활용을 염두에 두고 개발됐다. 메타 측에 따르면 라마 4 매버릭은 'GPT-4o'와 '제미나이 2.0 플래시'를 능가하는 추론 및 코딩 성능에 '딥시크 V3'와 비슷한 결과를 달성했다.

<이미지를 클릭하시면 크게 보실 수 있습니다> |

메타는 2880억개 활성 매개변수 모델인 '라마 4 베히모스' 출시도 예고했다. 회사 측이 역대 가장 강력하고 똑똑한 거대언어모델(LLM)이 될 것이라 기대하며 훈련 중인 라마 4 베히모스는 STEM 벤치마크에서 'GPT-4.5', '클로드 소네트 3.7', '제미나이 2.0 프로' 등 경쟁 모델보다 뛰어난 성능을 보이고 있다는 설명이다.

메타 측은 "개발자에게 개방형 솔루션을 제공해 필요에 따라 가장 안전하고 효과적인 경험을 만들 수 있도록 할 것"이라며 "글로벌 파트너와 협력해 오픈소스 커뮤니티에 도움이 되는 업계 전체 시스템 표준을 만들 것"이라고 전했다.

남도영 기자 hyun@techm.kr

<저작권자 Copyright ⓒ 테크M 무단전재 및 재배포 금지>

이 기사의 카테고리는 언론사의 분류를 따릅니다.

기사가 속한 카테고리는 언론사가 분류합니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.