|

<이미지를 클릭하시면 크게 보실 수 있습니다> |

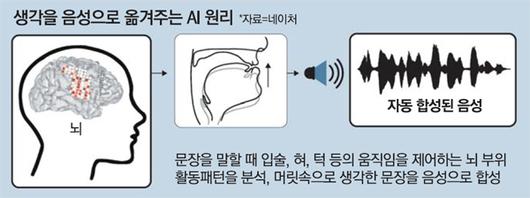

사람이 머릿속으로 떠올린 말을 곧바로 음성으로 옮겨 주는 인공지능(AI) 시스템이 개발됐다. 언어·음성 장애를 가진 환자는 물론, 뇌 활동이 가능하지만 사지를 움직이지 못하는 전신마비 환자와 대화하는 일도 가능해질 것으로 기대된다.

에드워드 창 미국 샌프란시스코 캘리포니아대 교수 연구진은 사람의 뇌 신호를 해독해 머릿속으로 떠올린 영어 문장을 음성 언어로 변환해 주는 기술을 개발해 간질 치료를 받고 있는 환자 5명을 대상으로 이 기술을 검증하는 데 성공했다고 국제학술지 '네이처' 25일자에 발표했다. 사람의 뇌와 컴퓨터를 연결하는 '뇌-컴퓨터 인터페이스(BCI)' 기술과 AI 딥러닝(심층기계학습) 기술을 접목한 결과다.

이전에도 뇌 신호로 사람의 의도를 파악해 컴퓨터 화면의 커서를 움직이거나 키보드를 눌러 주는 AI가 있었지만, 1분당 말할 수 있는 단어 수가 최대 8개(영어 기준) 정도에 그쳤다. 이 때문에 1분당 150개 단어(영어 기준)를 말하는 사람의 자연어 속도를 따라가지 못했다. 또 사람 뇌에 칩을 심어야 하는 부담도 있었다.

연구진은 피험자의 두개골 안쪽 대뇌피질 표면에 전극 패드를 붙이는 '뇌피질전도(ECoG)' 기술을 사용했다. 먼저 피험자들이 수백 개 문장을 말하는 동안 일어나는 뇌 활동 패턴과 음성 패턴 간 상관관계를 분석했다. 말소리를 낼 때 입술과 혀, 턱 등 조음기관과 성도(콧구멍부터 성대에 이르는 구간) 움직임을 조절하는 특정 뇌 부위가 활성화된다는 점에 착안했다.

이 같은 빅데이터를 토대로 훈련한 AI 시스템은 피험자들이 입 밖으로 소리를 내지 않고 문장을 말하는 시늉을 낼 때 나타나는 뇌 신호를 해독해 해당 문장을 음성으로 합성했다. 김준식 서울대 뇌인지과학과 교수는 "특정 패턴으로 목 근육이 움직일 때 어떤 톤과 주파수(피치)가 발생하는지 예측해 이를 기계적인 음성으로 합성해 주는 것"이라며 "사실상 모든 말을 옮겨 줄 수 있는 셈"이라고 설명했다.

기계적으로 합성한 101개 문장을 청중에게 들려준 뒤 어떤 말을 했는지 질문한 결과, 대다수가 말의 의미를 알아차릴 수 있는 것으로 조사됐다. 의도한 문장과 음성으로 합성된 문장의 일치도는 문장 길이에 따라 30~100%로 확인됐다. 약간의 어눌함은 있지만 말귀를 알아들을 수 있는 수준이라는 게 연구진 설명이다.

연구진이 공개한 동영상에 따르면 AI는 "The proof you are seeking is not available in books(네가 찾고 있는 증거는 책에 없어)"와 같은 일상적인 대화가 가능한 수준의 문장들을 사람의 음성과 매우 유사한 음성으로 합성해냈다.

창 교수는 "향후 기술을 발전시키면 말하지 못하거나 한 번도 말을 해본 적 없는 장애인에게도 충분히 적용할 수 있을 것"이라고 기대했다.

[송경은 기자]

[ⓒ 매일경제 & mk.co.kr, 무단전재 및 재배포 금지]

이 기사의 카테고리는 언론사의 분류를 따릅니다.

기사가 속한 카테고리는 언론사가 분류합니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.

언론사는 한 기사를 두 개 이상의 카테고리로 분류할 수 있습니다.